Why explainability suddenly matters for blockchain decisions

For years, crypto and blockchain enthusiasts повторяли мантру: «code is law». Смарт‑контракты детерминированы, блокчейн прозрачен, значит, всё и так понятно, верно? На практике оказалось наоборот. Как только в цепочку появляются сложные модели машинного обучения — от KYC‑скоров до MEV‑ботов и систем управления протоколами — решение уже принимает не код, а «чёрный ящик». Explainable AI for blockchain decision processes пытается вернуть прозрачность туда, где её незаметно отняли модели. И это важно не только для регуляторов; без объяснимости сложно строить доверие, открывать корпоративные бюджеты и масштабировать DeFi за пределы крипто‑пузыря.

Where AI is already making blockchain decisions (and hiding the logic)

В реальных проектах ai decision making for blockchain platforms уже сейчас встречается куда чаще, чем кажется новичку. Банки используют модели, чтобы решать, какой транзакции в сети Ethereum доверять меньше и отправить её на дополнительную AML‑проверку. Крупные DeFi‑протоколы доверяют алгоритмам выбор параметров ликвидности и процентных ставок. Кастодиальные сервисы оценивают риск кошелька, прежде чем дать пользователю вывести крупную сумму. Во всех этих случаях AI не просто предлагает рекомендацию — он фактически блокирует или разрешает движение миллионов долларов. Без объяснимости такая система превращается в идеальный источник конфликтов: пользователи видят только результат, но не знают, почему их транзакция внезапно попала под подозрение, хотя соседняя прошла без вопросов.

What “explainable AI” actually means in a blockchain context

Explainable AI часто подают как набор красивых визуализаций и тепловых карт. Для блокчейна такой подход слишком поверхностен. Здесь нужно не только «показать важные признаки», но и объяснить, как именно модель интерпретирует поведение адреса, токена или пула ликвидности. В контексте explainable ai blockchain solutions объяснимость можно разбить на три уровня: локальные объяснения конкретного решения (почему этот кошелёк пометили как рискованный), глобальное понимание модели (какие паттерны она считает подозрительными в целом) и проверяемость (можно ли формально зафиксировать логику в смарт‑контракте или он‑чейн‑доказательствах). Без всех трёх уровней мы рискуем получить замаскированную систему ручного одобрения под видом «умного алгоритма».

Technical details: basic XAI toolkit for on‑chain models

В типичном стеке blockchain analytics with explainable ai tools используются проверенные техники: SHAP‑значения для локальных объяснений, LIME‑подобные аппроксимации для сложных ансамблей, интерпретируемые модели (логистическая регрессия, деревья решений) для слоёв, критичных с точки зрения регуляторов. Если модель оценивает риск транзакции, для каждого решения можно сохранять в отдельном логе набор признаков, внёсших 80–90 % вклада в итоговый скор: доля взаимодействий с миксерами, частота участия в флэш‑кредитах, аномальные паттерны времени отправки. Такие логи затем либо хэшируются и коммитятся в блокчейн, либо используются для создания zk‑доказательства того, что решение основано на зафиксированной политике, а не на произвольном «взялось из ниоткуда».

Real‑world case: AML scoring that doesn’t feel like witchcraft

Рассмотрим упрощённый, но вполне реалистичный пример. Крупный европейский банк в 2023 году обрабатывал около 120 тысяч крипто‑транзакций в месяц через свою «белую» on‑/off‑ramp‑платформу. Их старый AML‑модуль знал только базовые санкционные списки и простые эвристики, поэтому давал около 18 % ложноположительных срабатываний. После перехода на explainable ai blockchain solutions банк добавил модель градиентного бустинга с XAI‑слоем. Итог: доля ложных тревог упала до 7–8 %, а среднее время проверки спорной транзакции сократилось примерно с 40 до 15 минут, потому что аналитики сразу видели ключевые факторы риска. Пользователь больше не слышит сухое «ваша транзакция заблокирована из‑за внутренней политики», а видит формализованные причины и приблизительную оценку риска, поддержанную данными из блокчейна.

Technical details: making AML explanations audit‑proof

Чтобы объяснения нельзя было «подкрутить постфактум», разработчики внедрили схему фиксации каждого расчёта. Модель выводит скор и набор признаков с их вкладом в итоговое решение. Далее формируется хэш этой структуры и записывается в отдельный служебный смарт‑контракт. В случае внешнего аудита банк может показать регулятору первоначальный JSON с объяснением и доказать, что он совпадает с тем, что было зафиксировано он‑чейн. Комбинация криптографической неизменяемости и xai models for blockchain risk management превращает обжалование решений в процесс, больше похожий на разбор полётов с «чёрным ящиком самолёта», а не на спор с непрозрачным алгоритмом.

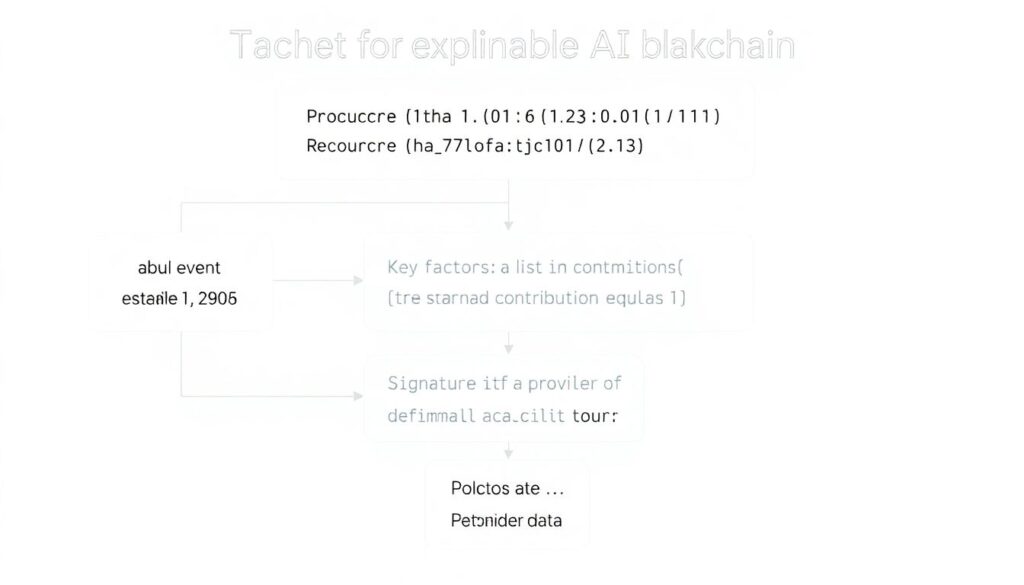

Unconventional idea №1: “Explainable or it doesn’t execute”

Обычно XAI считают внешним слоем над уже существующими AI‑сервисами. Но для смарт‑контрактов можно пойти дальше: сам протокол отказывается выполнять критичное действие, пока не получит формализованное объяснение. Представим lending‑платформу, которая использует off‑chain модель для динамического пересмотра коллатерализации. Вместо того чтобы слепо доверять API, контракт требует, чтобы вместе с новым коэффициентом пришла структурированная объяснительная запись, подпись поставщика модели и ссылка на хэш, зафиксированный ранее. Если объяснение не соответствует ожидаемому формату или не проходит криптографическую проверку, изменение параметров просто не вступает в силу, а пользователи видят, что обновление отменено из‑за недостаточной прозрачности.

Technical details: minimal on‑chain explanation schema

Для такой схемы достаточно определённого словаря полей: идентификатор события (например, изменение LTV конкретного пула), версия политики, список ключевых факторов с нормированным вкладом (сумма вкладов равна 1), подпись поставщика enterprise blockchain explainable ai services и хэш исходного подробного отчёта. Смарт‑контракт валидирует только формат и подпись, оставляя тяжёлую часть логики off‑chain. Зато любой пользователь может проверить, что изменение было инициировано конкретной версией политики, а не неожиданным экспериментом разработчиков. Такая жёсткая связка explainable AI и on‑chain‑логики фактически создаёт новый класс протоколов — «принудительно объяснимые».

Unconventional idea №2: “Explain‑to‑earn” for model governance

Сегодня вознаграждения в экосистеме Web3 почти всегда завязаны на ликвидность или стейкинг. Однако есть ещё одна редкая, но ценная сущность — хорошие объяснения решений модели. Можно предложить радикальный подход: протокол создаёт «explain‑to‑earn»‑механику, где исследователи и аналитики получают вознаграждение за улучшение интерпретации уже работающих AI‑моделей. Например, DAO, управляющее рисками кредитного протокола, публикует набор кейсов: транзакции, ликвидации, аномальные ценовые движения. Участники пытаются построить альтернативные интерпретируемые модели, которые совпадают по качеству с исходной, но дают более наглядные и компактные объяснения. Если новая интерпретация уменьшает среднее время анализа инцидента хотя бы на 30 % (определяется по результатам внутренних разборов) — автор получает токены.

Technical details: benchmarking alternative explanations

Чтобы этот подход не превратился в «красивые истории задним числом», протоколу нужна чёткая метрика полезности. Один вариант — использовать симуляции: берём исторические данные, моделируем кризис (например, падение цены залога на 50 % за сутки) и сравниваем, сколько времени у реальных аналитиков уходит на принятие корректного решения при работе с разными объяснениями. Ещё один показатель — степень сжатия знаний: насколько меньше признаков требуется новой интерпретируемой модели для достижения того же уровня точности. Такое исследование в 2022 году показало, что грамотно подобранная sparse‑модель может сократить число значимых признаков в кредитных скоринговых системах на 40–60 % без заметной потери качества, что прямо уменьшает когнитивную нагрузку на риск‑команды.

Unconventional idea №3: Public “bias dashboards” for protocol AI

Уговорить пользователей поверить, что модель «честная», почти невозможно без прозрачной статистики перекосов. Вместо маркетинговых обещаний можно внедрить публичные «bias dashboards» для протоколов, где AI участвует в управлении. Такой дашборд показывает, как модель ведёт себя по отношению к разным классам пользователей и активов: частота блокировок по странам, размерам депозитов, времени активности, типам кошельков. В отличие от традиционного финтеха, в блокчейне это проще, потому что большинство признаков уже публично он‑чейн. Регулярный анализ подобных панелей помогает вовремя заметить, что, например, новый модуль безопасности стал непропорционально часто блокировать мелкие транзакции или адреса, использующие определённые кошельки.

Technical details: integrating bias metrics into blockchain analytics

Для построения таких панелей данные с on‑chain‑событий объединяются с результатами работы моделей и результатами апелляций пользователей. На этой основе формируются метрики: различия в доле отклонённых операций между группами, false positive rate, время до разблокировки. Система blockchain analytics with explainable ai tools позволяет не только видеть агрегированные показатели, но и быстро переходить к объяснению на уровне конкретной транзакции. Это критично в среде, где любое обвинение в дискриминации мгновенно подрывает доверие к протоколу и отражается на ТВЛ и объёмах торгов.

Why enterprises will care sooner than they expect

Корпоративный сектор долго относился к блокчейну с осторожностью, но за последние два‑три года ситуация резко изменилась. По оценкам различных консалтинговых агентств, объём рынка корпоративных блокчейн‑решений превышает уже несколько миллиардов долларов и продолжает расти двузначными темпами. Как только крупные игроки приходят в пространство, они приносят с собой требования комплаенса, аудита и объяснимости. enterprise blockchain explainable ai services становятся отдельной нишей: страховые компании требуют понимать, как AI‑модели оценивают риск смарт‑контрактов, банки — почему тот или иной кошелёк попадает в «серую зону», логистические компании — на основании каких факторов система блокирует грузовой документ в цепочке поставок. Без формализованных объяснений сделки срываются, а пилоты не переходят в промышленную эксплуатацию.

Technical details: compliance‑ready XAI architecture

Архитектура, ориентированная на корпоративных клиентов, почти всегда разделяет «слой принятия решений» и «слой интерпретации». Решение может быть принято сложным ансамблем или нейросетевой моделью, но параллельно формируется интерпретируемый отчёт, привязанный к бизнес‑понятиям: тип транзакции, подозрительные контрагенты, аномалии поведения. Такой отчёт сохраняется в неизменяемом журнале (внутренний permissioned‑блокчейн или внешняя сеть) и доступен как через API, так и через специализированные интерфейсы для аудиторов. Важно, что словарь признаков и структура отчётов согласованы с регулятором или отраслевым стандартом, чтобы процесс проверки не превращался в бесконечную расшифровку терминов дата‑саентистов.

Bringing it all together: pragmatic roadmap to explainable AI on blockchain

Чтобы не утонуть в теории, полезно разложить внедрение explainable AI for blockchain decision processes на несколько конкретных шагов. Такая поэтапность позволяет протоколам и компаниям двигаться от небольших улучшений к полноценной архитектуре, где прозрачность заложена в основу, а не прикручена в последний момент для галочки в отчёте.

1. Начать с критичных решений

Сначала стоит идентифицировать небольшое число узких мест, где ошибка AI особо болезненна: блокировка вывода средств, ликвидация позиций, отказ в участии в токенсейле. Для этих зон вводятся жёсткие требования к объяснениям и логированию, в то время как второстепенные рекомендации (например, подсказки по оптимизации газ‑фии) могут работать с облегченным XAI‑режимом.

2. Встроить XAI в пользовательский опыт

Объяснение должно быть не только где‑то в логе, но и в интерфейсе: «мы заблокировали вашу транзакцию, потому что X, Y и Z, вот что вы можете сделать». Опыт показывает, что даже короткое, но чёткое пояснение снижает нагрузку на поддержку в разы, а доверие к платформе растёт гораздо сильнее, чем от любой скидки на комиссии.

3. Автоматизировать апелляции и пересмотр решений

Если модель ошибается, пользователю нужно понятное «окно обжалования». Можно реализовать автоматический пересмотр спорных кейсов другим алгоритмом или меньшей, но более интерпретируемой моделью. В случаях, когда обе модели расходятся, решение передаётся на ручной разбор с обязательной фиксацией аргументов.

4. Регулярно публиковать метрики прозрачности

Помимо привычных TVL и объёмов торговли, протокол может публиковать «метрики объяснимости»: долю решений с доступным пользователю объяснением, среднее время ответа на апелляцию, количество выявленных и исправленных bias‑паттернов. Такой публичный отчёт быстро превращает прозрачность в реальное конкурентное преимущество.

5. Экспериментировать с он‑чейн‑принуждением

На зрелой стадии развития проекта можно начать переводить XAI‑политику непосредственно в смарт‑контракты: запрет на изменение критичных параметров без валидации объяснения, привязка выплат команде к уровню прозрачности решений, интеграция с DAO‑голосованием за обновления моделей и их интерпретаций. Это превращает explainability из «приятного дополнения» в фундаментальное свойство протокола.

В итоге ai decision making for blockchain platforms не обязано быть загадочной магией, которой верят только разработчики. Вернув в центр процесса объяснения, проверяемость и формальные гарантии, экосистема может совместить сильные стороны децентрализованных технологий и современных AI‑моделей, не жертвуя ни скоростью, ни безопасностью, ни доверием пользователей.