Why decentralized cloud + AI acceleration is suddenly a big deal

Traditional clouds were built вокруг центров обработки данных, где всё контролирует один провайдер. Для обычных веб‑приложений это работает, но как только вы запускаете серьёзные нейросети, выясняется, что «железа» не хватает, очереди растут, а счёт за GPU напоминает платёж за частный самолёт. Отсюда вырос интерес к модели decentralized cloud computing platform with AI acceleration, где вычислительные ресурсы собираются из множества независимых узлов, а смарт‑контракты и криптография отвечают за честность и оплату.

Чем децентрализованный облачный ИИ отличается от привычного

В централизованном облаке вы платите конкретной компании и доверяете ей всё: от хранения данных до подсчёта результатов. В децентрализованной модели задачи дробятся и улетают на сеть машин, принадлежащих разным участникам. Кто‑то отдаёт простаивающий GPU, кто‑то — целый серверный парк. Алгоритмы распределения и блокчейн‑уровень помогают убедиться, что вычисления проведены честно, а исполнители получили вознаграждение.

Как это работает на практике: архитектура в двух словах

Основные компоненты децентрализованного AI‑облака

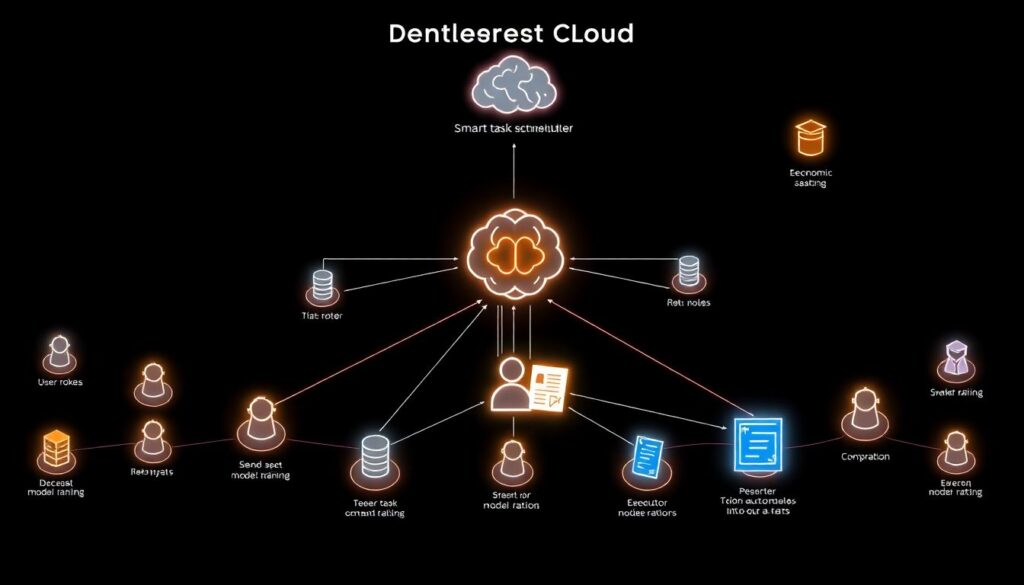

Если упростить схему, децентрализованный ИИ‑облако выглядит как пиринговая сеть с умным планировщиком задач. Поверх неё развёрнут уровень экономических стимулов — токены, стейкинг, репутация узлов. Пользователь отправляет задачу, например обучение модели, а сеть подбирает исполнителей с подходящими GPU и проверяет результат через повторное вычисление, криптографические доказательства или выборочную валидацию.

- Клиенты — компании и разработчики, которым нужны мощные GPU для обучения и инференса.

- Провайдеры — владельцы видеокарт и серверов, сдающие мощности в аренду.

- Протокол — набор правил распределения задач, оплаты и проверки корректности.

- Инфраструктура — контейнеры, оркестрация, сетевые туннели, зашифрованное хранение.

Где тут ускорение ИИ, а не просто «облако на блокчейне»

AI‑ускорение — это не только про GPU. Это ещё и про оптимизацию маршрутов задач, умную загрузку видеопамяти и выбор точных, но экономичных моделей. Хорошая distributed gpu cloud hosting for deep learning заранее индексирует устройства по типу чипа, объёму памяти, пропускной способности сети и даже по температуре, чтобы не снижалась частота. В результате тяжёлые модели уходят на A100 или H100, а мелкие инференс‑запросы — на более дешёвые карты.

Практические кейсы: кто уже использует децентрализованный AI‑клауд

Стартап в генеративной графике: как ужаться в бюджете в 4 раза

Небольшой студии, генерирующей рекламные ролики на основе текстовых запросов, нужно было обучать и дообучать диффузионные модели. В классических облаках за месяц обучения нескольких моделей выставлялся чек в десятки тысяч долларов. Перейдя на best decentralized gpu cloud for ai training, команда распределила обучение по сети независимых провайдеров, выбрала только проверенные узлы и сократила расходы почти вчетверо, сохранив время эпох на приемлемом уровне.

Главный приём — комбинированная стратегия:

часть экспериментов запускалась на самых дешёвых узлах с более старыми GPU, а финальные модели и тонкая настройка — только на быстрых картах с высокой репутацией. В децентрализованной сети это можно настроить через теги и фильтры, не переплачивая за каждую тестовую гипотезу.

Исследовательская группа в университете: обход дефицита GPU

Университетская лаборатория занималась моделями обработки медицинских изображений, но столкнулась с тем, что локальный кластер забит очередями на недели вперёд. Администраторы не хотели открывать доступ к конфиденциальным данным вовне. Решение нашлось гибридное: через web3 cloud computing for machine learning workloads учёные вынесли «тяжёлое» вычисление признаков на анонимизированных данных в децентрализованное облако, а окончательное обучение на реальных медицинских снимках проводили на своём кластере.

Чтобы не провалиться по безопасности, данные перед загрузкой проходили несколько стадий: деперсонализацию, агрегацию и шифрование. На стороне сети выполнялись задачи без возможности восстановить исходные персональные данные. Такой подход снял очереди на обучение, а юридический отдел согласился с архитектурой после проверки процедур анонимизации и журналирования доступов.

Web3‑игра с он‑чейн‑экономикой: масштабирование ИИ‑NPC

Создатели блокчейн‑игры хотели использовать динамических NPC на основе языковых моделей. Запускать такие модели напрямую в смарт‑контрактах невозможно, поэтому они решили rent decentralized ai compute power online. Логика выглядела так: смарт‑контракт фиксирует запрос игрока, оракул отправляет задачу в сеть провайдеров, там выполняется инференс, а ответ возвращается обратно в игру. Ключевой момент — проверка честности результатов и защита от подмены ответов с выгодой для мошенников.

- Контракты хранят хэши запросов и ответов для аудита.

- Сложные действия NPC подтверждаются несколькими независимыми узлами.

- Репутация провайдеров влияет на вероятность выбора для «дорогих» задач.

- Игровой токен используется для оплаты вычислений и стейкинга исполнителей.

Как выбирать децентрализованное AI‑облако под конкретную задачу

Критерии, на которые стоит смотреть до деплоя

Большинство платформ обещают максимум производительности и безопасности, но реальные различия скрыты в деталях. Перед тем как разворачивать пайплайн, стоит оценить не только цену за час GPU, но и полную стоимость владения — включая траты на DevOps, мониторинг и возможные простои. Хорошая decentralized cloud computing platform with ai acceleration даёт инструменты для автоматических тестов стабильности узлов и прозрачную статистику по отказам.

- Доступные типы GPU, объём VRAM и поддержка нужных фреймворков.

- Среднее время отклика и стабильность сети по регионам.

- Механизмы верификации результатов и экономика штрафов.

- Юридические аспекты: где физически находятся сервера, кто отвечает за инциденты.

Оптимизация затрат на обучение и инференс

Финальная цена проекта зависит не только от тарифа. Разбейте задачи по классам: долгие, но терпимые к задержкам тренировки можно отправить на менее дорогие узлы, а онлайн‑инференс и A/B‑тестирование — только на самые надёжные и близкие географически. В распределённой сети проще играть комбинациями: фиксируете бюджет и заранее настраиваете верхний предел цены за час, чтобы экспромт с экспериментальными моделями не превратился в финансовый сюрприз.

Практические советы по внедрению децентрализованного AI‑облака

Начните с изолированного экспериментального пайплайна

Лучше не переносить сразу весь продакшен в новый стек. Выберите один сервис — например, вспомогательную модель для генерации подсказок или бэк‑офисный аналитический отчёт. Оберните его в контейнер, подготовьте инфраструктуру как код и прогоните на нескольких платформах. Такой подход к distributed gpu cloud hosting for deep learning позволяет сравнить производительность и надёжность без риска положить основной продукт. А заодно вы проверите UX платформы и качество документации.

Следите за данными: шифрование и контроль доступа

Чем более раздроблена инфраструктура, тем важнее дисциплина обращения с данными. Шифруйте всё, что уходит в сеть, используйте временные ключи и принцип минимально необходимого доступа. Для особо критичных наборов данных оставляйте «тяжёлую» часть на своём кластере, вынося наружу только обобщённые или синтетические версии. Встраивайте в пайплайн автоматические проверки того, какие датасеты отправляются на внешние узлы, и журналируйте каждое обращение.

Интегрируйте наблюдаемость как обязательное требование

Децентрализованный клауд без мониторинга превращается в чёрный ящик. Поднимите единую панель, где видно задержки, процент ошибок, время очередей и стоимость по каждому эксперименту. Добавьте алерты на резкие скачки цены или времени ответа. Это поможет не только ловить проблемы, но и оптимизировать маршрутизацию: часть задач можно перенаправить на другие регионы или типы узлов, если сеть перегружена или подорожала в конкретном сегменте.

Куда всё движется: децентрализованные GPU как базовый слой ИИ

По мере роста числа моделей и запросов централизация становится всё менее выгодной: дефицит железа, регулирование, риски отключения целых регионов. Экосистема web3 cloud computing for machine learning workloads пытается ответить на это за счёт открытого рынка вычислений. Если правильно подойти к вопросам безопасности и наблюдаемости, децентрализованная сеть GPU может стать для ИИ тем же, чем интернет стал для обмена информацией: невидимым, но критичным слоем, который просто работает, пока вы сосредоточены на моделях и продуктах.