Историческая справка

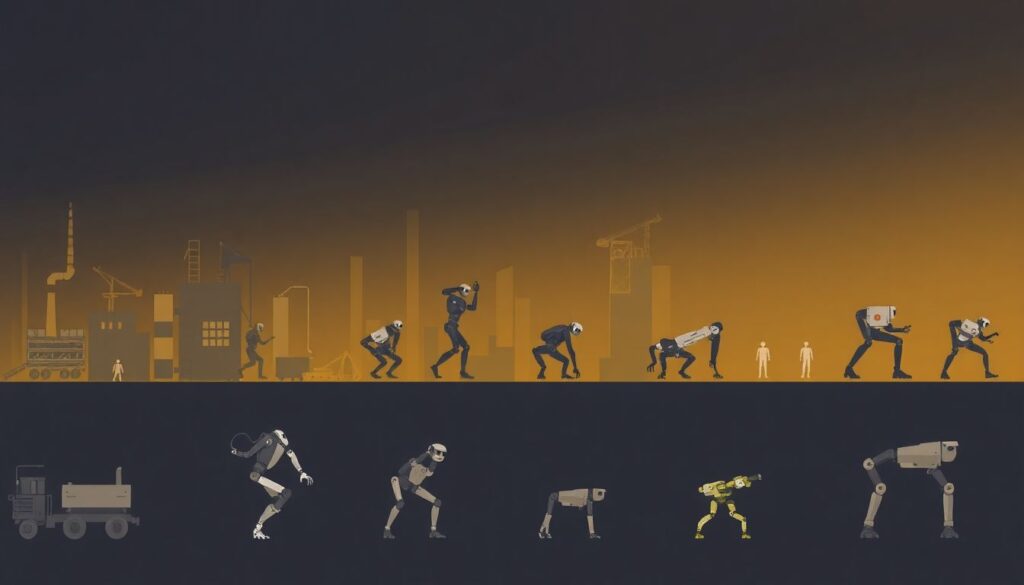

Автономная робототехника как направление начала активно развиваться с конца XX века, когда появились первые интеллектуальные системы, способные выполнять задачи без прямого вмешательства человека. Первые роботы ограничивались программируемыми действиями в контролируемой среде, например, на заводских конвейерах. Однако с развитием технологий машинного обучения, компьютерного зрения и сенсорного восприятия роботы постепенно вышли за пределы промышленных целей и начали взаимодействовать с людьми в повседневной жизни. Уже в 2000-х годах обсуждение юридических и этических вопросов автономных систем приобрело реальную актуальность, особенно после инцидентов с участием беспилотных автомобилей и боевых дронов. Именно в этот период началось формирование нормативной базы, затрагивающей как права роботов, так и ответственность их создателей и операторов.

Базовые принципы прав и ответственности

Обсуждение прав и обязанностей в автономной робототехнике опирается на несколько фундаментальных понятий. Прежде всего, необходимо различать юридическую и моральную ответственность. Пока ни один автономный робот не признаётся субъектом права, то есть не может нести юридическую ответственность. Вся ответственность за действия машин распределяется между:

– Разработчиком интеллектуального программного обеспечения

– Производителем аппаратной платформы

– Владельцем или оператором системы

В юридической практике существует принцип «предсказуемости поведения системы». Если разработчик не обеспечил должный уровень безопасности и предсказуемости, то он может быть привлечён к ответственности. С другой стороны, если оператор нарушил инструкции или эксплуатировал систему вне допустимых условий, ответственность ложится на него. Таким образом, возникает сложная сеть юридических отношений, где необходимо балансировать между инновациями и безопасностью.

Нормативные подходы в разных странах

Разные страны вырабатывают собственные подходы к регулированию автономных систем. Например:

– В ЕС действует «Этика искусственного интеллекта» с акцентом на прозрачность, безопасность и контроль

– В США регулирование осуществляется на уровне штатов, особенно в вопросах беспилотного транспорта

– Южная Корея разрабатывает законодательство, в котором обсуждается возможность признания роботов «электронными лицами»

Хотя консенсус в вопросе признания прав самих роботов пока не достигнут, международные организации, включая ООН и IEEE, активно работают над едиными стандартами ответственности и этики.

Примеры реализации и кейсы из практики

Реальные случаи с участием автономных систем подчёркивают сложность и актуальность правовых вопросов. Один из наиболее известных кейсов — авария с участием беспилотного автомобиля Uber в 2018 году, в результате которой погиб пешеход. Расследование показало, что система обнаружила человека, но не инициировала торможение из-за настройки, исключающей ложные срабатывания. В результате обвинения были предъявлены не разработчику ИИ, а оператору, находившемуся в машине.

Другой пример — использование боевых дронов в зоне конфликта. В 2020 году ООН зафиксировала применение автономного оружия в Ливии, которое, по имеющимся данным, самостоятельно выбрало цель и атаковало. Это вызвало волну дискуссий о необходимости запрета полностью автономного вооружения, так как в таких случаях невозможно установить, кто несёт ответственность за применение силы.

Также стоит отметить использование социальных роботов в Японии, которые взаимодействуют с пожилыми людьми. Хотя они не совершают опасных действий, возникает вопрос о защите личных данных и психологическом воздействии на уязвимые группы населения.

Частые заблуждения и проблемные зоны

Несмотря на стремительное развитие технологий, общественное восприятие автономных систем часто искажено. Среди основных мифов можно выделить следующие:

– Роботы сами несут ответственность за свои действия

На практике юридическая ответственность лежит исключительно на людях — создателях, пользователях или компаниях-владельцах.

– ИИ способен принимать объективные и «беспристрастные» решения

Алгоритмы обучаются на данных, которые могут содержать предвзятость. Это означает, что результат работы ИИ может быть неэтичным или дискриминационным.

– Чем выше автономность, тем выше безопасность

Уровень автономности не всегда коррелирует с безопасностью. Без адекватной проверки и контроля даже высокоавтономные системы могут допустить критические ошибки.

Кроме того, существует недопонимание границ между автономией и программируемостью. Пользователи могут считать, что робот «сам решает», тогда как поведение устройства строго определяется алгоритмами и условиями работы.

Ключевые вызовы для регулирования

На сегодняшний день перед юридической и инженерной средой стоят следующие вызовы:

– Установление прозрачной цепочки ответственности

– Разработка стандартов верификации ИИ-действий

– Обеспечение этического и правового соответствия международных систем

Также важно создать механизмы «объяснимости» решений ИИ, чтобы в случае инцидента можно было точно реконструировать, почему система приняла то или иное решение.

Заключение

Права и ответственность в автономной робототехнике — это не только правовой, но и философский, этический вопрос. Современное регулирование должно учитывать не просто юридические аспекты, но и общественные риски, потенциальные злоупотребления и долгосрочные последствия распространения автономных систем. Баланс между развитием технологий и защитой человеческих прав требует междисциплинарного подхода и постоянной корректировки законодательства. В ближайшие годы именно этот баланс станет отправной точкой для создания зрелой правовой среды в эпоху автономии машин.