Необходимые инструменты для построения автономной аналитической архитектуры

Современные архитектуры аналитики требуют комплексных программно-аппаратных решений, объединяющих машинное обучение, обработку больших данных и автоматизацию принятия решений. Ключевыми инструментами автономной аналитики выступают следующие компоненты:

1. Платформы для автономной аналитики — такие как Google Cloud Vertex AI, IBM Watson Studio, Microsoft Azure Synapse и Oracle Autonomous Data Warehouse — предоставляют масштабируемые среды для сбора, подготовки и анализа данных.

2. Средства автоматизированного машинного обучения (AutoML) — AutoML позволяет бизнес-аналитикам и инженерам без глубоких навыков в Data Science быстро строить и внедрять модели прогнозирования.

3. Механизмы потоковой обработки данных — Apache Kafka, Spark Streaming и Flink обеспечивают непрерывную поставку и анализ данных в реальном времени.

4. Инструменты ETL/ELT нового поколения — Fivetran, dbt, Airbyte и Apache NiFi автоматизируют подготовку и трансформацию данных, минимизируя участие человека.

5. Системы управления метаданными и каталогами данных — такие как Alation, Collibra и DataHub, способствуют обеспечению качества и доступности данных в распределённых средах.

Интеграция этих компонентов создаёт основу для автономной аналитики решений, способных самостоятельно выявлять закономерности, адаптироваться к изменяющимся условиям и формировать рекомендации без постоянного вмешательства аналитиков.

Поэтапный процесс построения автономной аналитики

Реализация современной архитектуры автономной аналитики для бизнеса требует поэтапного подхода, включающего проектирование, внедрение и эксплуатацию интеллектуальной инфраструктуры:

1. Определение бизнес-целей и метрик эффективности

Первоначально необходимо определить конкретные задачи: прогнозирование спроса, выявление отклонений, автоматизация KPI-отчетности и т.д. Это позволяет сформировать приоритеты при выборе архитектурных компонентов и моделей.

2. Архитектурное проектирование

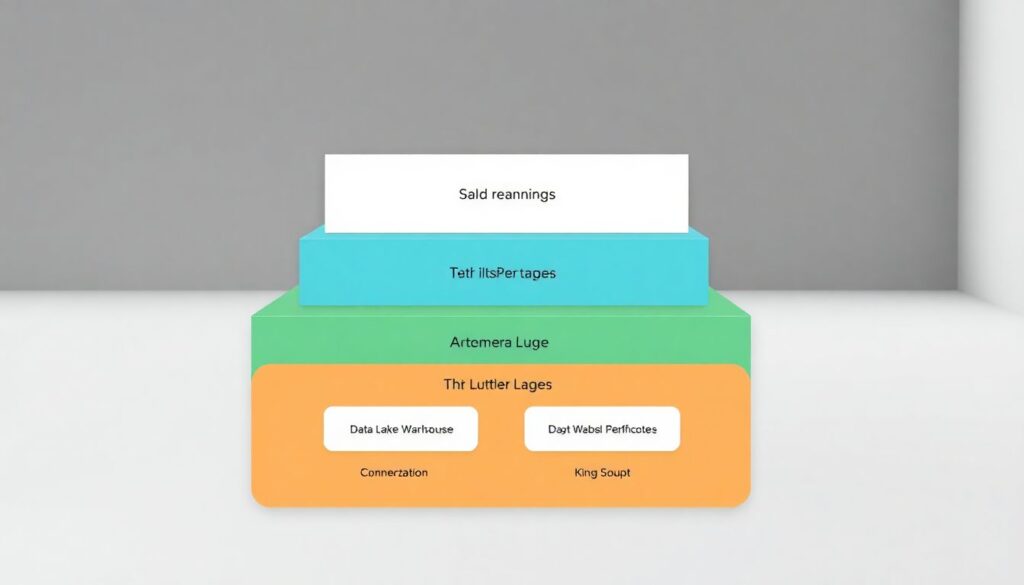

На этом этапе проектируется архитектурный стек. В типичной современной архитектуре автономной аналитики выделяются следующие уровни:

– Уровень данных: хранилища данных (Data Lake, Data Warehouse), обеспечивающие централизованное хранение и доступ к структурированным и неструктурированным данным.

– Уровень обработки: системы ETL/ELT, платформы потоковой обработки и компоненты очистки данных.

– Уровень моделирования: AutoML-платформы и библиотеки машинного обучения.

– Уровень визуализации и принятия решений: BI-инструменты с возможностью внедрения рекомендаций моделей в бизнес-процессы.

3. Автоматизация пайплайнов

Автономная аналитика требует полной автоматизации всех этапов — от ingest-процессов до деплоймента моделей. Использование GitOps-подходов и CI/CD-инструментов (например, Jenkins, GitHub Actions, MLflow) позволяет достичь высокого уровня автономности и повторяемости.

4. Мониторинг и обратная связь

Для устойчивости системы необходимо внедрение мониторинга качества данных (Data Quality), отслеживания производительности моделей (Model Monitoring) и автоматической обратной связи. Это обеспечивает самокорректирующуюся систему с адаптивным поведением.

5. Интеграция с бизнес-процессами

Финальный этап — это внедрение результатов аналитики в реальные рабочие процессы. Это может включать автоматическую настройку цен, персонализацию маркетинга, управление запасами в реальном времени и другие сценарии, усиливающие автономную аналитику для бизнеса.

Устранение неполадок и обеспечение надежности

Несмотря на высокий уровень автоматизации, архитектуры автономной аналитики нуждаются в контроле, особенно в условиях изменения внешней среды, обновления моделей или сбоев в данных.

1. Проблемы качества данных — наиболее частая причина деградации аналитических моделей. Использование Data Observability-инструментов (например, Monte Carlo, Great Expectations) позволяет отслеживать отклонения в потоках и структуре данных.

2. Дрейф моделей — со временем модели могут терять точность. Важно реализовать автоматическое переобучение на основе новых данных и метрик (model retraining pipelines).

3. Инфраструктурные сбои — отказоустойчивость достигается за счёт контейнеризации (Docker), оркестрации (Kubernetes) и использования облачных масштабируемых сервисов.

4. Неинтерпретируемые рекомендации — важно обеспечивать прозрачность решений моделей с помощью Explainable AI (XAI) подходов, таких как SHAP, LIME и интегрированных визуализаций в BI-инструментах.

Своевременное обнаружение и устранение неполадок критично для поддержания непрерывной работы платформ для автономной аналитики и доверия со стороны бизнеса.

Заключение

Современные архитектуры аналитики трансформируются в полностью автономные системы, минимизирующие вмешательство человека и повышающие скорость принятия решений. Инструменты автономной аналитики позволяют организациям не только анализировать исторические данные, но и предсказывать будущие события с высокой точностью. Благодаря интеграции AutoML, потоковой аналитики и систем мониторинга, автономная аналитика решения становятся неотъемлемой частью цифровой трансформации. Для успешной реализации таких систем требуется стратегический подход, грамотная архитектура и постоянная адаптация к изменениям бизнес-среды.

Автономная аналитика для бизнеса — это не просто тренд, а необходимый шаг для достижения устойчивого конкурентного преимущества в условиях быстро меняющегося рынка.